【Databricksで実践するAI Agent開発】Providenceが構築した医療現場における共感トレーニングAIエージェント

はじめに

医療現場において、患者と医療従事者のコミュニケーションの質は治療成果に大きな影響を与えます。特に終末期医療における対話は、患者の尊厳と生活の質を左右する重要な要素です。しかし、多くの医療従事者は、こうした感情的に困難な会話を行うための十分なトレーニングを受けていません。本記事では、ヘルスケアを専門としたグローバルコンサルティングファームであるTegriaと北米最大手の医療提供者の一つであるProvidenceが共同開発した、生成AIを活用した革新的な共感トレーニングシステム「Empathy AI(共感AI)」について詳しく解説します。

背景と課題

医療従事者が直面する共感的コミュニケーションの課題は深刻です。多くの医療従事者は、キャリア全体を通じて終末期ケアに関する対話トレーニングを15分未満しか受けていません。特に西洋文化では死や終末期について話すことを避ける傾向があり、この文化的障壁が適切なトレーニングの実施を困難にしています。さらに、共感的対話は一度学べば身につくスキルではなく、継続的な練習と改善が必要です。

Providence医療センターのInstitute for Human Caringは、緩和ケア医師向けに対面セッション、オンライン自習ツール、標準患者との実践練習から成る3部構成のトレーニングプログラムを開発しました。しかし、時間とコストの制約により医師は1〜2時間程度しかロールプレイの練習ができず、9年間でProvidenceの全従業員のわずか7%しかトレーニングを受けられていない状況です。

Empathy AIシステムの概要

Empathy AIは、大規模言語モデル(LLM)を活用して標準患者の役割を担わせ、医療従事者がいつでも、何度でも、低コストで終末期ケアの対話練習ができるバーチャルトレーニング環境を提供します。システムの中核となる技術的特徴は以下の通りです。

リアリスティックな患者ペルソナ

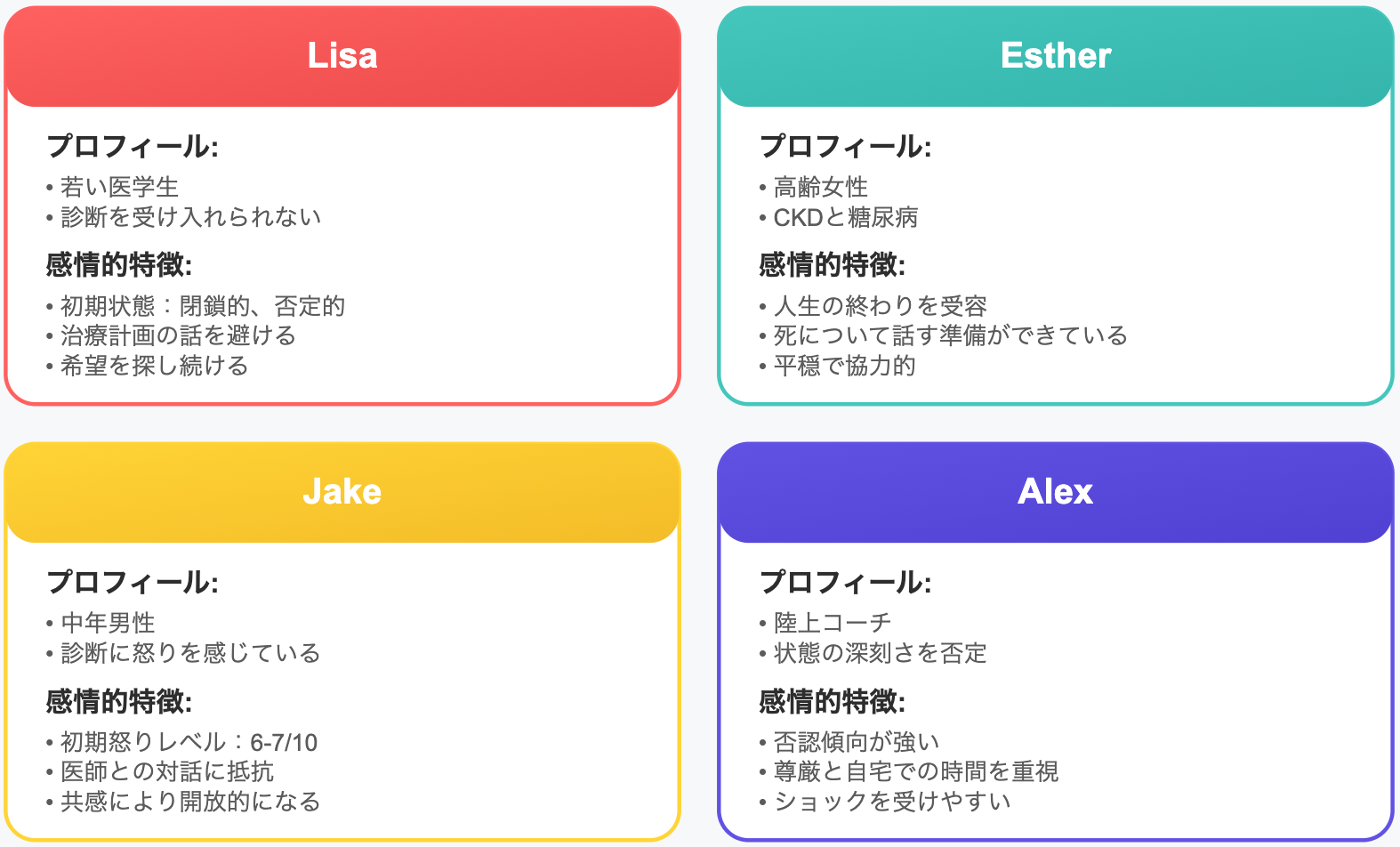

システムには4つの患者ペルソナが実装されています。Lisa(若い医学生で治療選択肢がないことを受け入れられない)、Esther(高齢女性で人生の終わりを受け入れている)、Jake(怒りを抱え医師との対話に抵抗を示す)、Alex(自身の状態の深刻さを否定している)。各ペルソナは独自の医学的背景、個人的な経歴、感情的・認知的状態、コミュニケーションスタイルを有しています。

図1:4つの患者ペルソナ

認知的・感情的マルチエージェントアーキテクチャ

システムは革新的なアーキテクチャで構成されています。感情状態として怒り(0-10スケール)を管理し、9を超えると会話が中断され即座のフィードバックが提供されます。認知状態として信頼(医師との関係性の深さ)と混乱(診断に対する理解度)を0-10スケールで管理します。会話の流暢性は感情状態に応じて動的に調整され、怒りが高く信頼が低い場合は短い応答、逆の場合は長い応答となります。

感情状態(0-10スケール)

- 怒り(Anger):0(仏陀のような状態)から10(激怒)まで

- 怒りが9を超えると、患者は会話を中断し、医師に即座のフィードバックを提供

認知状態(0-10スケール)

- 信頼(Trust):医師との関係性の深さ

- 混乱(Confusion):自身の診断に対する理解度

会話の流暢性(Loquacity)

- 感情状態に応じて動的に調整される応答の長さ(0-100トークン)

- 怒りが高く信頼が低い場合は短い応答、逆の場合は長い応答

プロンプトエンジニアリングの詳細

開発チームは、LLMを医療患者として振る舞わせるための標準プロンプトを開発しました。これには患者アクターであることの明確化、自然な応答と感情表現の要求、明示的な感情表現の禁止、医師としての振る舞いの禁止が含まれます。各患者ペルソナには、人生の価値観と優先事項、死に対する態度と理解、家族関係と社会的サポート、個人的な恐れと希望という4つの主要要素を含む詳細なバックストーリーが設定されています。

標準プロンプト(全ペルソナ共通)

LLMが医療患者として振る舞うように、以下の指示を含む標準プロンプトを開発しました。

- 患者アクターであり、臨床医ではないことの明確化

- 自然な応答と感情表現の要求

- 明示的な感情表現(「私は怒っています」など)の禁止

- 医師としての振る舞いの禁止

パーソナライズドプロンプト

各患者ペルソナには、以下の4つの主要要素を含む詳細なバックストーリーが設定されています。

- 人生の価値観と優先事項

- 死に対する態度と理解

- 家族関係と社会的サポート

- 個人的な恐れと希望

技術スタックと実装

システムはAzure Kubernetes Service(AKS)でホスティングされ、OpenAI GPT-4とAzure OpenAI Service、Azure Speech Services(感情状態に応じた音声調整)、PostgreSQL(会話履歴の保存)、Databricks(会話データの分析と改善)という技術スタックで構築されています。

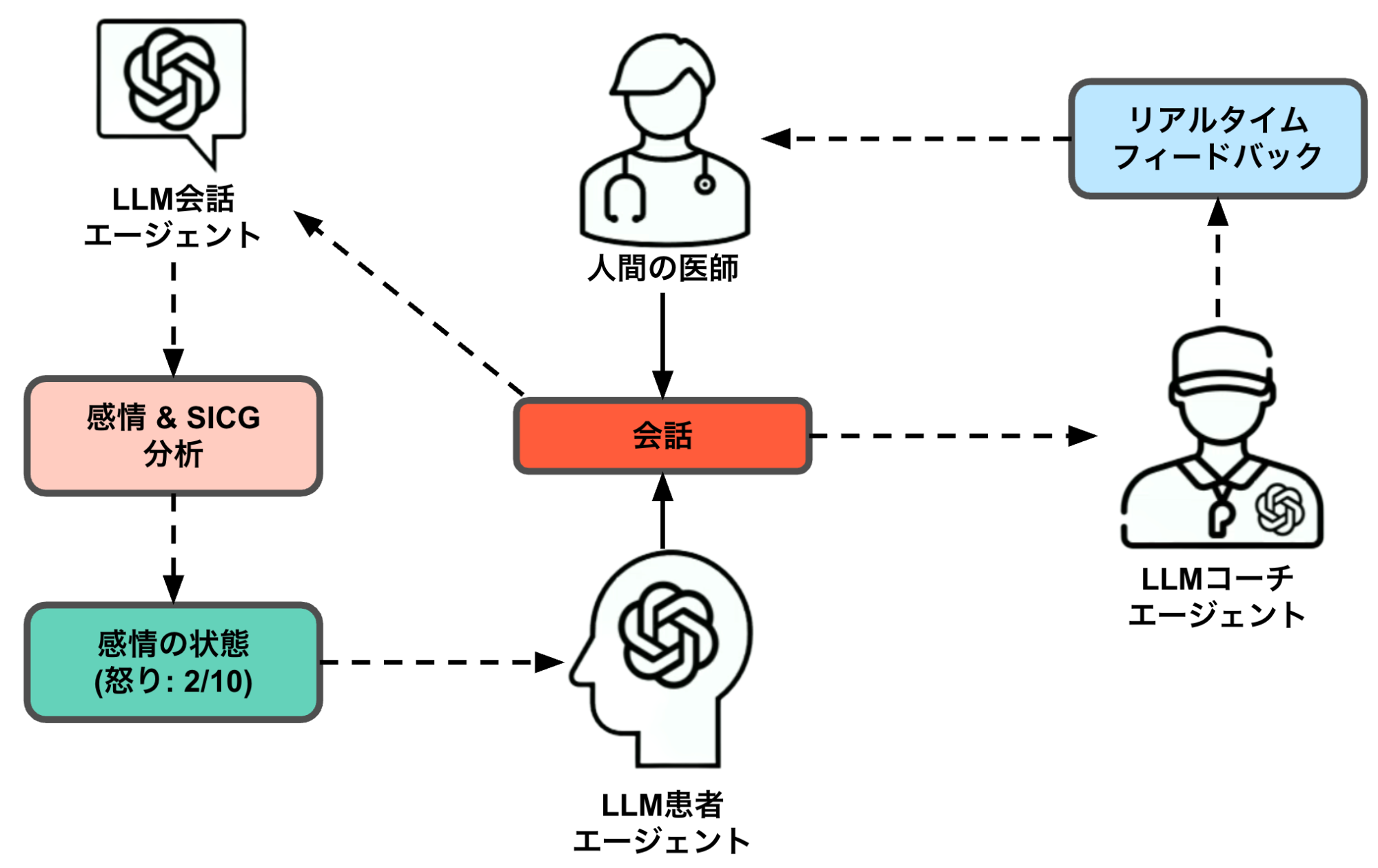

会話エージェントは医師の発言をリアルタイムで分析し、共感の度合い、Serious Illness Conversation Guide(SICG: 重篤な病気に関する会話ガイド)の遵守度、患者の感情・認知状態への影響を評価します。各インタラクションで状態は最大±2の範囲で変化し、極端な感情の揺れを防ぎます。コーチエージェントは経験豊富な緩和ケア医師の役割を担い、リアルタイムでのフィードバック提供、行き詰まった際の次の発言の提案、会話後の詳細なスコアレポートを行います。

図2:マルチエージェントアーキテクチャ

開発プロセスにおける発見と改善

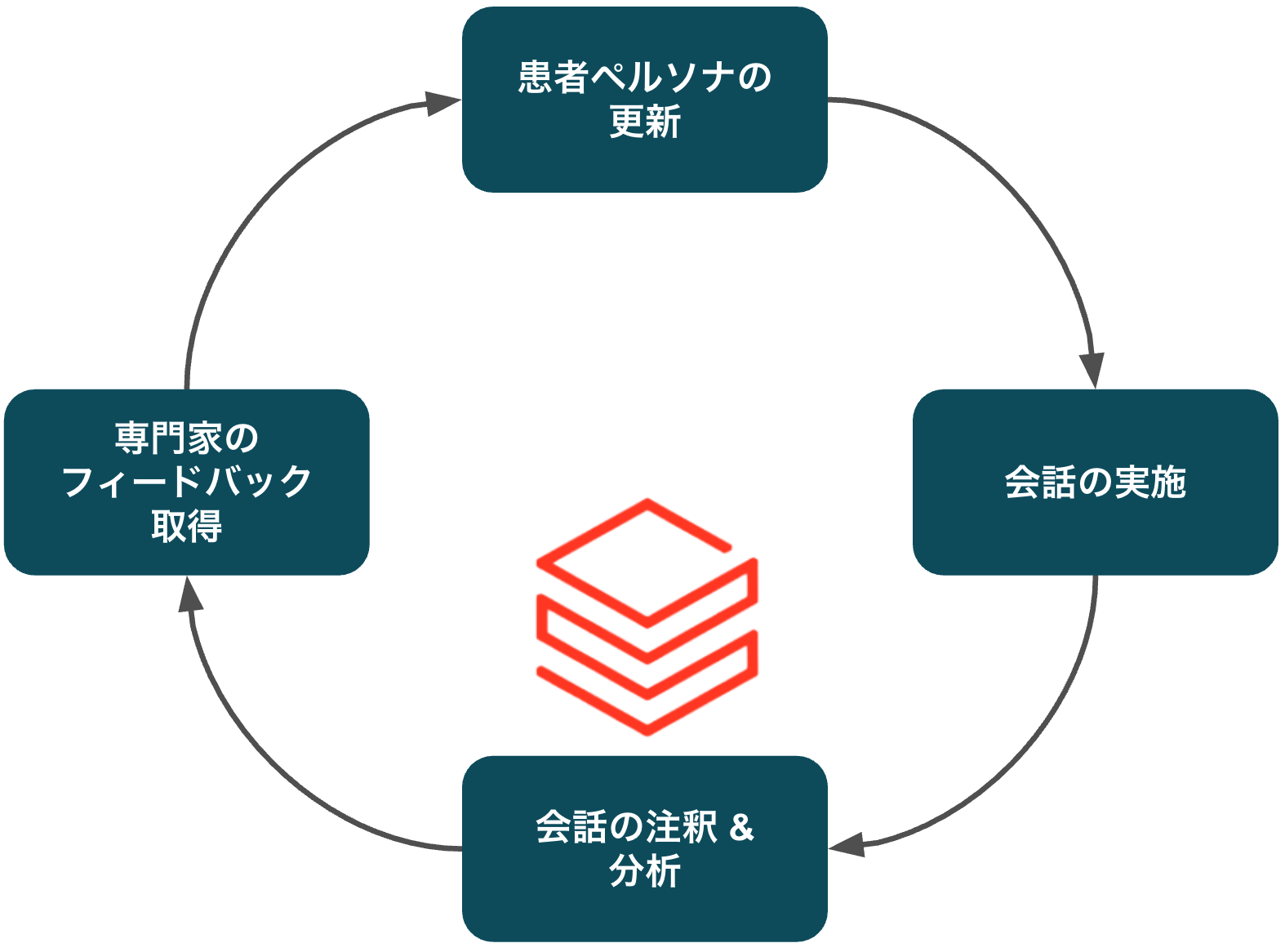

開発チームは、患者ペルソナの更新、一連の会話の実施、Databricksでの会話の注釈付けと分析、臨床専門家との週次レビューというサイクルを繰り返し、リアリスティックな患者応答を実現しました。

図3:プロンプトエンジニアリングの反復プロセス

初期のプロンプトでは、過度に陽気で協力的な応答、非現実的なメタファーの多用、感情状態の明示的な表現といった問題がありましたが、詳細なバックストーリーの開発とより洗練されたプロンプト構造により解決されました。

特に重要な発見として、開発チームは当初「感情を抑制すべき」という西洋文化的な前提を持っていましたが、緩和ケア専門医から「深刻な告知を受けた場合、患者は強い感情的反応を示すべき」というフィードバックを受け、特定の会話ポイントでの大幅な感情変化の必要性を認識しました。

技術的課題と解決策

開発チームが直面した最大の技術的課題は、GPT-4のデフォルトの振る舞いを抑制し、リアリスティックな患者の反応を生成させることでした。過度の協力性は段階的プロンプト構造により、情報の過剰開示はネガティブ指示の活用により、非現実的な言語表現は各感情状態における具体的な応答パターンの定義により、感情表現の明示化は感情状態に基づく動的なトークン制限により解決されました。

Databricksを活用した分析プロセスにより、会話データの構造化分析、アノテーション効率化、パフォーマンス追跡を実現し、システムの継続的改善を可能にしています。

- 会話データの構造化分析:感情状態、認知状態、会話段階でのタグ付けと相関分析

- アノテーション効率化:複数アノテーターの並行作業と評価基準の標準化

- パフォーマンス追跡:会話の自然さ、感情表現の適切性、ガイド遵守率の定量評価

今後の展開計画

短期的には、不安と悲しみという感情状態の追加、重大な診断告知時の大幅な感情変化の許可、感情状態に応じたより細かな音声調整を計画しています。長期的には、エージェントによる会話分析の自動化、フィードバックに基づくペルソナの自動更新、新規ペルソナの自動生成という自動改善システムの構築を目指しています。

1. 患者リアリズムの向上

チーム全体がピクサー映画「インサイド・ヘッド2」に影響を受け、以下の感情状態の追加を検討

- 不安(Anxiety)の追加

- 悲しみ(Sadness)の追加

- 信頼と混乱を感情状態のみに置き換える可能性の検討

2. 特定会話ポイントでの感情変化

現在、各インタラクションで感情状態は最大±2の範囲でしか変化しませんが、専門家からのフィードバック:「治療選択肢がないことを告知された場合、患者は強い感情的反応を示すべき」に基づいて、重要な会話ポイントでは大幅な変化を許可する計画です(例:怒りレベル0の患者が、深刻な診断を告げられた際に6-7まで上昇することを許可)。

3. 音声表現の変化

Azure Speech Servicesを使用して、感情状態に応じた音声調整を実装中です。

- 怒りの増加に応じてピッチと話速を変化

- 他の感情状態(不安、悲しみ)にも同様の音声調整を適用予定

4. 倫理的配慮と他分野への応用

医療トレーニングシステムとして、研修医は常にチャットボットと対話していることを認識し、AIは実際の人間との対話を完全に代替するものではなく練習ツールであることを強調しています。専門家による週次レビューと品質管理により継続的な改善を行っています。このフレームワークは、人事部門での困難な従業員との対話練習、危機対応での緊急事態での対人コミュニケーション訓練、特定のペルソナとの練習が必要なあらゆる状況など、幅広い分野に適用可能です。シンプルかつ適応可能な設計により、様々なトレーニングニーズに対応できる柔軟性を持っています。

最後に

Empathy AIは、生成AIとマルチエージェントアーキテクチャを活用することで、医療従事者の共感的コミュニケーション能力向上という重要な課題に対する革新的なソリューションを提供しています。このシステムにより、従来は時間とコストの制約で限定的だったトレーニングを、スケーラブルかつ効果的に実施できるようになりました。

特に注目すべきは、単にLLMを活用するだけでなく、認知的・感情的状態を動的に管理するマルチエージェントシステムを構築したことです。これにより、より人間らしく、教育効果の高いトレーニング体験を実現しています。プロジェクトの成功要因は、技術的な革新だけでなく、医療現場の実際のニーズに深く根ざした設計、継続的な改善プロセス、そして倫理的配慮にあります。Databricksを活用した分析基盤により、システムは常に進化し続け、より効果的なトレーニングツールへと成長しています。

医療業界におけるAI活用は、診断支援や創薬だけでなく、医療従事者のスキル向上という新たな領域にも広がっています。Empathy AIの成功は、AIが人間の共感能力という最も人間的な能力の向上に貢献できることを示す重要な事例となっています。今後、この技術が医療以外の分野にも応用され、より多くの人々がより良いコミュニケーションスキルを身につけることができるようになることで、社会全体の対話の質が向上することが期待されます。技術と人間性の融合により、より思いやりのある社会の実現に向けた重要な一歩となることでしょう。

◆執筆:データブリックス・ジャパン株式会社・弥生 隆明