週2500回以上使われる社内チャットボットを支えるAmazon Bedrock Knowledge Basesで作るRAG

.png)

株式会社LayerX / Tomoaki

メンバー / フルスタックエンジニア / 従業員規模: 501名〜1,000名 / エンジニア組織: 51名〜100名

| 利用機能 | ツールの利用規模 | ツールの利用開始時期 | 事業形態 |

|---|---|---|---|

Amazon Bedrock Knowledge Bases | 101名〜300名 | 2025年8月 | B to B |

| 利用機能 | Amazon Bedrock Knowledge Bases |

|---|---|

| ツールの利用規模 | 101名〜300名 |

| ツールの利用開始時期 | 2025年8月 |

| 事業形態 | B to B |

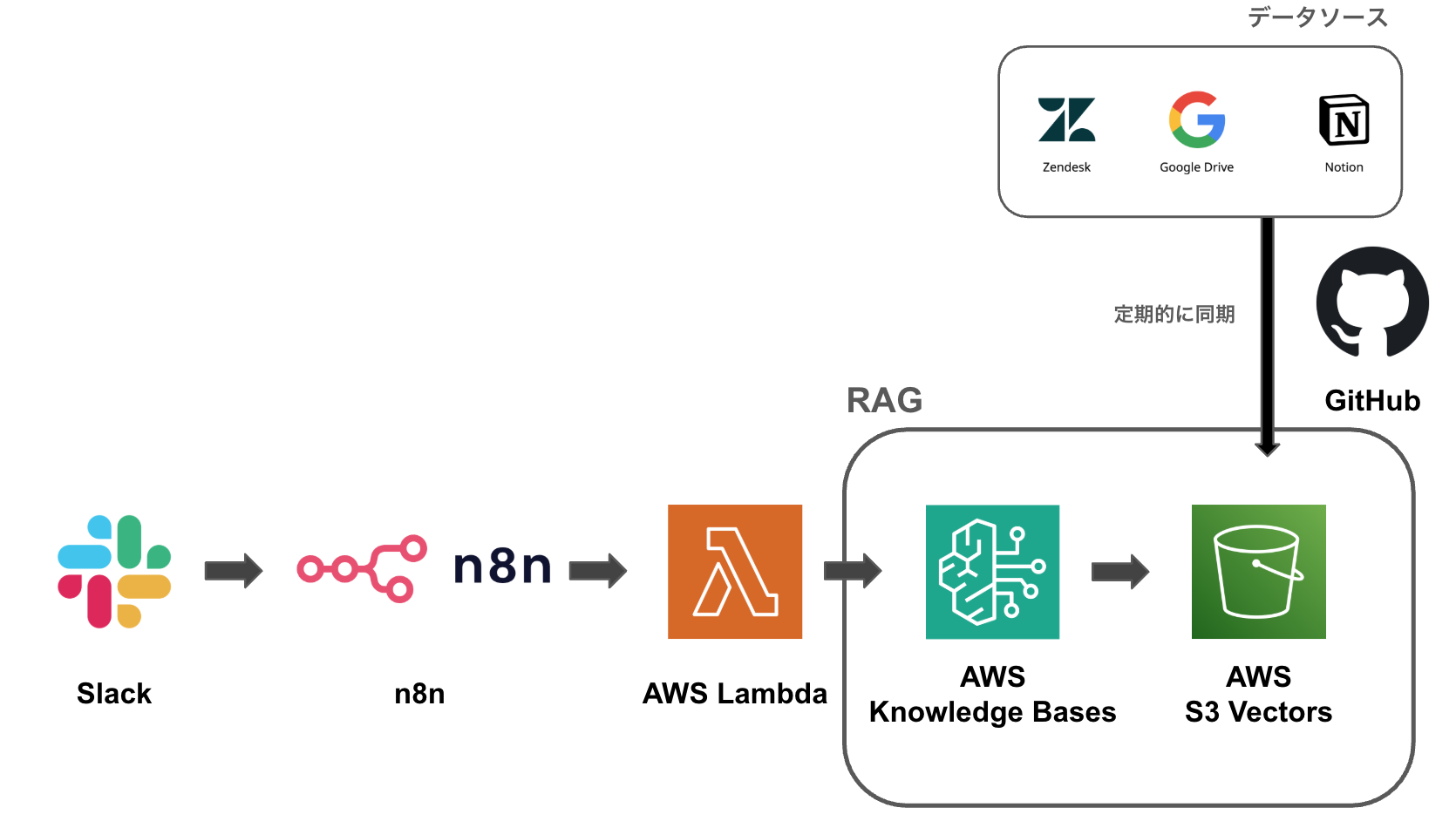

アーキテクチャ

アーキテクチャの意図・工夫

データ同期の効率化

現在サポートしているデータソースはZendesk, Google Drive, Notionの3つです。これらをGitHub Actions を用いて定期的に取得し、S3へ格納しています。その際、基本的には差分のみを更新対象とすることで、同期にかかるコストと処理時間を最小限に抑えています。

データ形式の統一による検索精度向上

元データは Google Slides, PDF, Markdown など形式が様々ですが、ベクトルデータベースへのインデクシング前にすべてのデータをMarkdown形式に変換・統一しています。これにより、フォーマットの違いによるノイズを排除し、安定した検索性能を実現しました。

回答の検証可能性の担保

さらに、回答の検証可能性を高めるために、Amazon Bedrock Knowledge Basesの メタデータフィルタリング機能 を利用しています。ソースデータのURLをメタデータに付与することで、回答時にソースとなるデータの内容だけでなく、参照元のURLもセットで提示可能となりました。 詳細は こちらの資料 をご覧ください。

なお、Slack Botやn8n側の具体的な実装アーキテクチャについては、LayerX TechBook 1 に寄稿された upamune 氏の記事「16: 社内の疑問をバクソク解決 - n8n × RAG × Slack botの実践ガイド」にて詳しく解説されていますので、あわせてご参照ください。

導入の背景・解決したかった問題

導入背景

ツール導入前の課題:チャットボットの乱立とスケールの限界

もともと、セールスやカスタマーサクセスといったビジネスサイドのメンバーから、「プロダクトの仕様についてチャットで即座に確認したい」「お客様からのセキュリティチェックシートやRFI(情報提供依頼書)への回答作成を効率化したい」という強いニーズがありました。

当初は各チームが個別に工夫し、Notion上のFAQをn8nでつなぎこんだSlackチャットボットが乱立していました。しかし、当時の主流だったチャットボットは回答生成のたびにNotion上のFAQデータを全件取得してコンテキストに詰め込むという「力技」の実装でした。 そのため、「FAQが増えれば増えるほど動作が遅くなり、コストがかかり、精度が落ちる」というスケールしないアーキテクチャの限界を迎えていました。

目指していた状態

乱立したボットを統合し、裏側であらゆるデータソースをインデクシングした1つのRAGを参照する構成への転換を目指しました。 メンテナンスの手間をかけずとも、高い性能を維持したまま、データが増えても高速で安価に動作するシステムを目指しました。

比較検討したサービス

- Dify

- Amazon Bedrock Knowledge Bases (S3 Vectors)

- Amazon Bedrock Knowledge Bases (OpenSearch)

比較した軸

- スケールできること: データ量や同時アクセスが増えても性能が維持できること。

- メンテが簡単であること: 簡単にデータソースを追加できること。

- 安価であること: 全社的に高頻度で利用してもコストが許容範囲であること。

選定理由

- 「メンテナンスの容易さ」 フルマネージドサービスであるため、ベクトルデータベースの管理やインデックス作成のパイプラインを自前で構築・運用する必要がなく、データソース(S3)を更新するだけでRAGが維持できる点が決め手になりました。DifyはAPI経由でデータソースの追加することが可能ですが、自前で実装する部分が多かったりメンテナンスコストが高く選択肢としては外れました。

- 「高いコストパフォーマンス」 Amazon Bedrock Knowledge Basesのベクトルデータベースの主な選択肢としてはS3 VectorsとOpenSearchがあります。高度な検索機能を必要とするようなレイテンシの制約が高い操作には OpenSearchが向いてきますが、チャットボットであればLLMの推論時間が長く、RAGの検索時間のレイテンシはほとんど無視できるので今回はコスト面で優位性のあるS3 Vectorsを採用しました。

導入の成果

運用の集約と効率化: 乱立していたチャットボットを1つに統合し、開発・メンテナンスリソースを一箇所に集約できました。

検索体験の向上: Notion、Google Drive、Zendeskなどあらゆるデータソースを定期同期するRAGにより、データ量が増えても検索性能が落ちないスケーラブルな環境が整いました。

高い利用率: 2026年1月時点で週に約2,500回利用されており、特に入社歴の浅いメンバーの業務効率化に貢献しています。

導入時の苦労・悩み

回答の検証可能性(ハルシネーション対策)

生成AIは無関係なトピックを組み合わせて「もっともらしい嘘」をつく傾向があります。 利用者には入社直後のメンバーも多くいるため、誤った情報を正解と信じ込むリスクがありました。回答のソースとなるデータが即座に確認できない状態であり、いかに信頼性を担保するかが課題でした。

データソースのS3への集約パイプライン

Amazon Bedrock Knowledge Basesは、S3にデータを配置した後のベクトル化はフルマネージドで自動化されます。 一方で、その前工程である「データ収集」の段階において、Notion、Zendesk、Google Slidesなど社内に散らばるデータソースを、いかに低コストかつ高頻度でS3へ同期させるかが、RAGの性能を高く維持する上での鍵となりました。

導入に向けた社内への説明

上長・チームへの説明

RAGの構築は急務であったため、導入すること自体への反対意見は特にありませんでした。

Difyと比較した際の優位性は「構築・運用コストの低さ」です。DifyもAPI経由でインデックスの更新は可能ですが、周辺機能を自前で実装する手間が発生します。その点、Bedrock Knowledge Basesはマネージドで手間が少なく、さらにAWSのサービスであるためIAMなどの権限設定やエコシステムの恩恵を受けられる点が、採用への大きな安心材料であると説明しました。

また、タイミングよくS3 Vectorsの発表があり、コスト面でもかなり安価に実現できる見込みが立ったことも、スムーズな導入決定につながりました。

活用方法

- 事業部全体で週に約2500回チャットボットが呼ばれている(2026年1月時点)

よく使う機能

- RetrieveAndGenerate

- Claude Haiku 4.5

ツールの良い点

- 構築・運用の手軽さ: S3にソースデータを保存するだけで簡単にRAGが構築でき、データの更新を検知して自動でベクトルデータベースのインデックスを更新する運用も容易です。

- モデルの追従性: Amazon Bedrock経由で、常に最新の高性能な生成モデルに切り替えて回答精度を高められます。

ツールの課題点

- ベクトルデータベース周辺のブラックボックス化: マネージドサービスである分メンテナンスは容易な一方でハイブリッド検索や重み付けといった細かいチューニングができなかったり、ベクトル化する時のチャンキング方法も細かく設定できないという課題があります。

今後の展望

チャットボットにとらわれず社内の生産性を高める上でさまざまな用途でRAGを利用できれば良いなと思っています。特にセールスメンバーのオンボーディングや継続学習する上でのコンテンツ作成等に役立てていきたいなと思っています。

.png)

株式会社LayerX / Tomoaki

メンバー / フルスタックエンジニア / 従業員規模: 501名〜1,000名 / エンジニア組織: 51名〜100名

よく見られているレビュー

.png)

株式会社LayerX / Tomoaki

メンバー / フルスタックエンジニア / 従業員規模: 501名〜1,000名 / エンジニア組織: 51名〜100名

レビューしているツール

目次

- アーキテクチャ

- 導入の背景・解決したかった問題

- 活用方法